Los editores rusos ya están experimentando con la grabación automática de audiolibros; en el futuro, se puede confiar a la inteligencia artificial la traducción de las series y el doblaje con las voces de sus actores favoritos. Acerca de las características de dichas tecnologías y cuánto tiempo llevará crearlas.

El habla oral se vuelve escrita

En YouTube, los subtítulos automáticos para videos se crean mediante software de reconocimiento de voz y traducción de voz a texto. Se basa en redes neuronales de autoaprendizaje. Esta opción tiene más de diez años, pero el resultado aún está lejos de ser ideal. La mayoría de las veces, solo puede captar el significado general de lo que se dijo. Cual es la dificultad?

norte

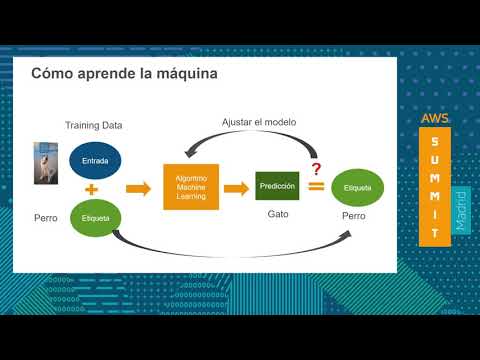

Digamos, explica Andrey Filchenkov, jefe del laboratorio de aprendizaje automático de la Universidad ITMO, que estamos construyendo un algoritmo para el reconocimiento de voz. Esto requiere entrenar una red neuronal en una gran matriz de datos.

Se necesitarán cientos, miles de horas de grabaciones de discursos y su correcta comparación con los textos, incluido marcar el inicio y el final de las frases, cambiar de interlocutores, etc. Esto se llama recinto. Cuanto más grande sea, mejor será el entrenamiento de la red neuronal. Se han creado corpus realmente grandes para el idioma inglés, por lo que el reconocimiento es mucho mejor. Pero para el ruso o, digamos, el español, hay muchos menos datos y para muchos otros idiomas no hay ningún dato.

“Y el resultado es apropiado”, concluye el científico.

“Además, evaluamos el significado de una palabra, una frase en una película no solo por el sonido, la entonación del actor y sus expresiones faciales también son importantes. ¿Como interpretas esto? - agrega Sergey Aksenov, profesor asociado del Departamento de Tecnología de la Información de la Universidad Politécnica de Tomsk.

Video promocional:

“¿Cómo manejar las características del habla fluida? ¿Articulación borrosa, esbozos, interjecciones, pausas? Después de todo, dependiendo de esto, el significado cambia, como en "no se le puede perdonar". ¿Cómo enseñar a una máquina a determinar dónde tiene una coma el hablante? ¿Y en poesía? " - enumera Marina Bolsunovskaya, jefa del laboratorio "Sistemas de procesamiento de datos de transmisión industrial" del Centro NTI SPbPU.

Los proyectos más exitosos, según el experto, se encuentran en áreas estrechas. Por ejemplo, un sistema para reconocer el discurso profesional de los médicos utilizando términos médicos, desarrollado por el grupo de empresas RTC, ayuda a los médicos a mantener un historial médico.

“Aquí puede delinear claramente el área temática y resaltar las palabras clave en el habla. El médico enfatiza específicamente ciertas secciones con entonación: quejas del paciente, diagnóstico”, aclara Bolsunovskaya.

Otro problema lo señala Mikhail Burtsev, jefe del laboratorio de sistemas neuronales y aprendizaje profundo en MIPT. El hecho es que hasta ahora la máquina tiene más éxito en reconocer texto cuando una persona habla que varias, como en las películas.

Traducción con contexto

Tomemos un video en inglés, por ejemplo, un corte de la serie de televisión "Game of Thrones", y activemos los subtítulos automáticos en ruso. Es probable que lo que veamos nos haga reír.

Fotograma de * Juego de Tronos *.

Sin embargo, en la traducción automática, la tecnología ha logrado un éxito impresionante. Por lo tanto, Google Translate traduce textos en idiomas comunes de manera bastante tolerable, a menudo solo se requiere una edición mínima.

El hecho es que el traductor de redes neuronales también está entrenado en una gran variedad de datos iniciales correctamente etiquetados: un corpus paralelo, que muestra cómo debería verse cada frase en el idioma original en ruso.

“Construir estos edificios es muy laborioso, caro y requiere mucho tiempo, lleva meses y años. Para entrenar una red neuronal, necesitamos textos del tamaño de la Biblioteca de Alejandría. Los modelos son universales, pero mucho depende del idioma. Si proporciona una gran cantidad de datos, por ejemplo, en Avar, y la traducción será de alta calidad, pero para Avar simplemente no existe tal cantidad de datos”, dice Andrey Filchenkov.

“La traducción es un producto separado que está relacionado con el original, pero no es igual a él”, dice Ilya Mirin, director de la Escuela de Economía Digital de la Universidad Federal del Lejano Oriente. - Un ejemplo típico son las traducciones de películas extranjeras de Dmitry Puchkov (Goblin) en los años 90. Solo después de su trabajo quedó claro lo que estaba sucediendo allí. No pudimos encontrar nada adecuado de las versiones VHS. Alternativamente, intente traducir a un idioma que conozca bien, algo de The Master y Margarita. Por ejemplo, "con un manto negro con un forro ensangrentado". La máquina no puede hacer eso ".

norte

Las redes neuronales aprenden bien de muchos ejemplos típicos, pero las películas están llenas de significados y connotaciones complejas, bromas que no son accesibles a la máquina, no puede distinguirlas.

“En cada episodio de la serie animada Futurama hay una referencia al cine estadounidense clásico: Casablanca, Roman Holiday, etc. En esos momentos, para captar y reempaquetar el significado para quienes no han visto estas películas, el traductor debe encontrar una analogía cercana del contexto ruso. Una traducción automática incorrecta puede ser muy desalentadora para el espectador”, continúa Mirin.

En su opinión, la calidad de la traducción automática se acerca al 80 por ciento, el resto es especificidad que debe agregarse manualmente, involucrando a expertos. "Y si entre el 20 y el 30 por ciento de las frases requieren corrección manual, ¿para qué sirve la traducción automática?" - dice el investigador.

“La traducción es la etapa más problemática”, coincide Sergey Aksenov. - Todo depende de la semántica y el contexto. Las herramientas disponibles se pueden utilizar para traducción y actuación de voz automática, por ejemplo, dibujos animados para niños con vocabulario simple. Pero con la interpretación de unidades fraseológicas, nombres propios, palabras que remiten a los espectadores a algunas realidades culturales, surgen dificultades.

En películas y videos, el contexto es siempre visual y suele ir acompañado de música y ruido. A partir de la imagen, especulamos de qué está hablando el héroe. El habla convertida en texto carece de esta información, por lo que la traducción es difícil. Esta es la situación de los traductores que trabajan con subtítulos de texto sin ver la película. A menudo se equivocan. La traducción automática es la misma historia.

Discurso de voces de IA

Para doblar una serie traducida al ruso, necesita un algoritmo para generar voz natural a partir del texto: un sintetizador. Son creadas por muchas empresas de TI, incluidas Microsoft, Amazon, Yandex, y les está yendo bastante bien.

Según Andrey Filchenkov, hace un par de años, un minuto de doblaje de un sintetizador de voz tomaba varias horas, ahora la velocidad de procesamiento ha aumentado considerablemente. La tarea de síntesis de voz para algunas áreas donde se requieren diálogos neutrales está bastante bien resuelta.

Muchos ya dan por sentado una conversación con un robot en el teléfono, la ejecución de comandos desde un navegador de automóvil, un diálogo con Alice en un automóvil Yandex. Drive. Pero para el doblaje de series de televisión, estas tecnologías aún no son adecuadas.

“El problema es la emoción y la actuación. Hemos aprendido a hacer que la voz de la máquina sea humana, pero aún queda un largo camino por recorrer para que suene apropiado al contexto e inspire confianza. Una mala interpretación de la voz puede matar fácilmente la percepción de una película”, dijo Filchenkov.

Según Mikhail Burtsev, la síntesis de voz es bastante real. Sin embargo, esto es computacionalmente intensivo y no se puede hacer en tiempo real por un precio razonable.

“Hay algoritmos que sintetizan el habla que es similar a la de un actor en particular. Este es el timbre y la manera de hablar, y mucho más. Entonces, cualquier actor extranjero hablará ruso”, predice Burtsev. Espera un progreso notable en los próximos años.

Sergei Aksenov da de cinco a diez años para desarrollar herramientas para traducir y doblar obras complejas de los idiomas más comunes como el inglés. El científico cita el ejemplo de Skype, que hace varios años demostró la posibilidad de organizar lecciones en línea para escolares que hablan diferentes idiomas. Pero incluso entonces, el sistema no será ideal, tendrá que aprender constantemente: ganar vocabulario, tener en cuenta el contexto cultural.