Cuanto más fuerte entra la IA en nuestra vida diaria, más a menudo tiene que enfrentarse a complejos dilemas morales y éticos, que a veces no son tan fáciles de resolver para una persona viva. Los científicos del MIT intentaron resolver este problema y dotaron a la máquina de la capacidad de pensar en términos de moralidad, basándose en la opinión de la mayoría de las personas vivas.

Algunos expertos creen que la mejor manera de entrenar la inteligencia artificial para manejar situaciones moralmente difíciles es mediante el uso de la "experiencia colectiva". Otros argumentan que este enfoque no está exento de sesgos y que diferentes algoritmos pueden llegar a diferentes conclusiones del mismo conjunto de datos. ¿Cómo pueden las máquinas estar en una situación así, que obviamente tendrá que tomar decisiones éticas y morales difíciles cuando se trabaja con personas reales?

Intelecto y moralidad

norte

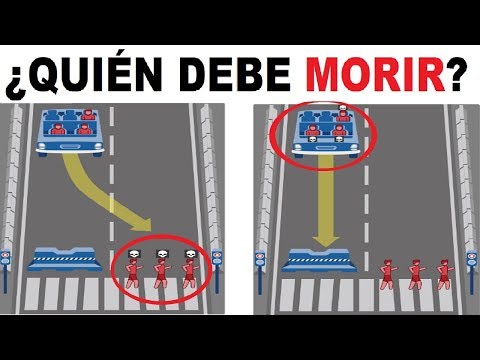

A medida que evolucionan los sistemas de inteligencia artificial (IA), los expertos intentan cada vez más resolver el problema de cuál es la mejor manera de darle al sistema una base ética y moral para realizar ciertas acciones. La idea más popular es que la IA saque conclusiones mediante el estudio de las decisiones humanas. Para probar esta suposición, los investigadores del Instituto de Tecnología de Massachusetts crearon la Máquina Moral. Se pidió a los visitantes del sitio web que tomaran decisiones sobre cómo debería actuar un vehículo autónomo cuando se enfrentaran a una decisión bastante difícil. Por ejemplo, este es un dilema familiar sobre un posible accidente, que tiene solo dos opciones para el desarrollo de eventos: un automóvil puede atropellar a tres adultos para salvar la vida de dos niños, o puede hacer lo contrario. ¿Qué opción elegir? ¿Y es posible, por ejemplo,sacrificar la vida de un anciano para salvar a una mujer embarazada?

Como resultado, el algoritmo reunió una enorme base de datos basada en los resultados de las pruebas, y Ariel Procaccia, del Departamento de Ciencias de la Computación de la Universidad Carnegie Mellon, decidió usarlos para mejorar la inteligencia de las máquinas. En un nuevo estudio, él y uno de los creadores del proyecto, Iyad Rahwan, cargaron la base completa del proyecto Moral Machine en la IA y le pidieron al sistema que prediga cómo reaccionaría el automóvil en piloto automático a escenarios similares, pero aún ligeramente diferentes. Procaccia quería demostrar cómo un sistema basado en el voto puede ser una solución para la inteligencia artificial “ética””. El propio autor del trabajo admite que dicho sistema, por supuesto, es todavía muy pronto para ser aplicado en la práctica, pero demuestra de manera excelente el concepto mismo de que es posible.

Moralidad cruzada

Video promocional:

La idea misma de elegir entre dos resultados moralmente negativos no es nueva. La ética usa un término separado para ello: el principio del doble efecto. Pero este es el campo de la bioética, pero nadie ha aplicado previamente un sistema de este tipo a un automóvil, por lo que el estudio despertó un interés especial entre los expertos de todo el mundo. El Copresidente de OpenAI, Elon Musk, cree que la creación de IA “ética” es una cuestión de desarrollar pautas o políticas claras para guiar el desarrollo del programa. Los políticos lo escuchan gradualmente: por ejemplo, Alemania creó los primeros principios éticos del mundo para los automóviles autónomos. Incluso Alphabet AI DeepMind de Google ahora tiene un departamento de ética y moral pública.

Otros expertos, incluido un equipo de investigadores de la Universidad de Duke, creen que la mejor manera de avanzar es crear un "marco general" que describa cómo la IA tomará decisiones éticas en una situación determinada. Creen que la unificación de puntos de vista morales colectivos, como en la misma Máquina Moral, hará que la inteligencia artificial sea aún más moral en el futuro que la sociedad humana moderna.

Críticas a la "máquina moral"

Sea como fuere, en la actualidad el principio de "opinión mayoritaria" dista mucho de ser fiable. Por ejemplo, un grupo de encuestados puede tener sesgos que no son comunes a todos los demás. El resultado será que las IA que reciben exactamente el mismo conjunto de datos pueden llegar a diferentes conclusiones basadas en diferentes muestras de esa información.

Para el profesor James Grimmelmann, que se especializa en la dinámica entre software, riqueza y poder, la idea misma de moralidad pública parece defectuosa. "No es capaz de enseñar la ética de la IA, solo dotarla de una apariencia de estándares éticos inherentes a una cierta parte de la población", dice. Y el propio Procaccia, como se mencionó anteriormente, admite que su investigación no es más que una prueba de concepto exitosa. Sin embargo, confía en que tal enfoque podría traer el éxito futuro de toda la campaña para crear una IA altamente moral. "La democracia, sin duda, tiene una serie de deficiencias, pero como sistema unificado funciona, incluso si algunas personas todavía toman decisiones con las que la mayoría no está de acuerdo".

Vasily Makarov